人工智能模型越来越聪明,但哪一个能真正在压力下解决问题?在本文中,我们让 o3、o4-mini 和 Gemini 2.5 Pro 接受了一系列激烈的挑战:物理难题、数学问题、编码任务和真实世界的智商测试。没有手把手教,没有轻松取胜,只有对思维能力的原始测试。我们将分析每款模型在不同领域的高级推理中的表现。无论您是在追踪人工智能的最新发展,还是只想知道谁能胜出,本文都能为您一一解答。

什么是o3和o4-mini?

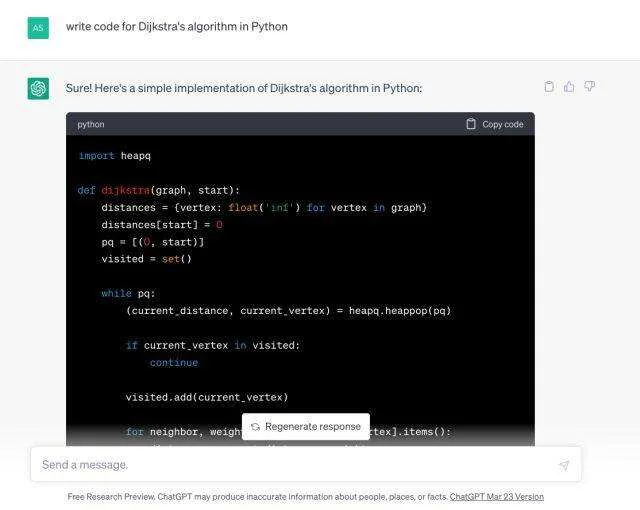

o3 和 o4-mini 是 OpenAI 最新的推理模型,是 o1 和 o3-mini 的后继者,它们通过运行更深、更长的内部“思维链”,超越了模式匹配。它们可以代理调用全套 ChatGPT 工具,擅长 STEM、编码和逻辑演绎。

- o3:旗舰模型,计算能力约为 o1 的 10 倍,能够“用图像思考”,进行直接的视觉推理;是深度分析任务的理想选择。

- o4-mini:紧凑、高效的对应模型,优化了速度和吞吐量;以更低的成本提供强大的数学、编码和视觉性能。

您既可以在 ChatGPT 中访问,也可以通过响应 API 访问。

o3和o4-mini的主要功能

以下是这些先进而强大的推理模型的一些主要特点:

- 代理行为:它们具有主动解决问题的能力,能自主确定复杂任务的最佳方法,并高效执行多步骤解决方案。

- 先进的工具集成:这些模型可无缝利用网络浏览、代码执行和图像生成等工具来增强其响应能力,并有效地处理复杂的查询。

- 多模态推理:他们可以处理视觉信息并将其直接整合到推理链中,从而能够在解释和分析文本数据的同时解释和分析图像。

- 高级视觉推理(“图像思维”):这些模型可以解读复杂的视觉输入,如图表、白板草图,甚至是模糊或低质量的照片。作为推理过程的一部分,它们甚至可以处理这些图像(缩放、裁剪、旋转、增强),以提取相关信息。

什么是Gemini 2.5 Pro?

Gemini 2.5 Pro 是谷歌 DeepMind 的最新人工智能模型,旨在提供比前代更高的性能、效率和功能。它是 Gemini 2.5 系列的一部分,代表专业级版本,为开发人员和企业在功能和成本效益之间取得了平衡。

Gemini 2.5 Pro的主要功能

Gemini 2.5 Pro 引入了多项显著增强功能。

- 多模式功能:该模型支持多种数据类型,包括文本、图像、视频、音频和代码库。因此,它可以处理各种输入和输出,成为不同领域的通用工具。

- 先进的推理系统:Gemini 2.5 Pro 的核心是其先进的推理系统,它能让人工智能在有条不紊地生成响应之前对信息进行分析。这种经过深思熟虑的方法可实现更准确、更贴近上下文的输出。

- 扩展的上下文窗口:它具有一个扩展的上下文窗口,可容纳 100 万个标记。这使它能够同时处理和理解更大量的信息。

- 增强的编码性能:该模型在编码任务方面有显著改进,可为开发人员提供更高效、更准确的代码生成和帮助。

- 扩展的知识库:与大多数其他模型相比,该模型使用了更多最新数据进行训练,知识截止日期为 2025 年 1 月。

您可以通过 Google AI Studio 或 Gemini 网站(针对 Gemini Advanced 订阅者)访问 Gemini 2.5 Pro。

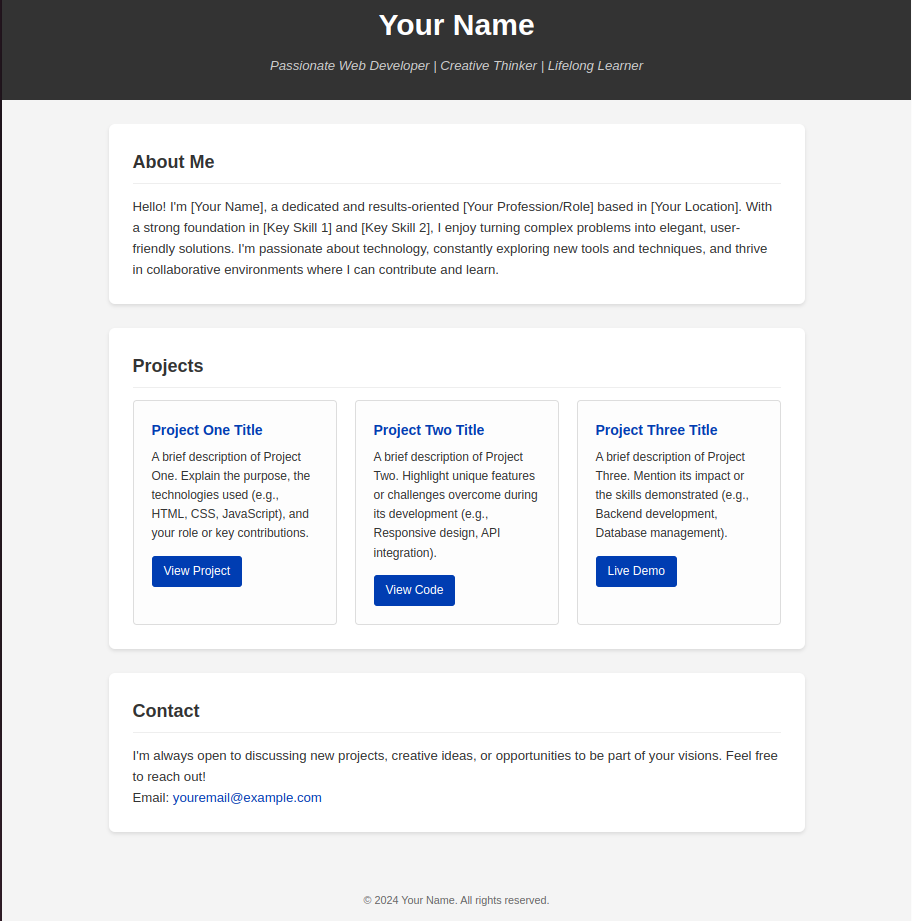

o3 vs o4-mini vs Gemini 2.5:任务对比对决

为了看看哪种模型能在现实世界的各种挑战中脱颖而出,我们让 o3、o4-mini 和 Gemini 2.5 在五项截然不同的任务中正面交锋:

- 共振衰减推理:计算色散气体介质的吸收系数、相位速度排序和共振折射率。

- 数列之谜:破解微妙增长序列,找出缺失项。

- LRU 缓存实现:在代码中设计高性能、恒定时间的最近最少使用缓存。

- 响应式作品集网页:使用语义 HTML 和自定义 CSS 创建一个简洁、移动友好的个人网站。

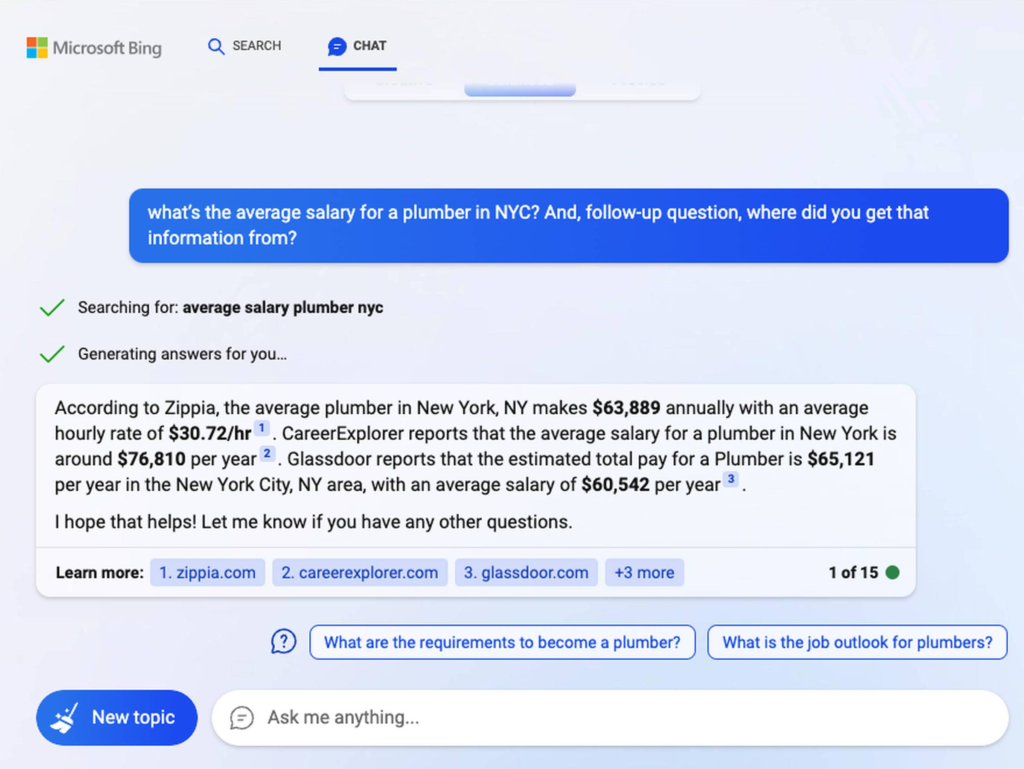

- 多模式任务分解:分析每种模式如何应对基于图像的挑战。

每个测试都会在深度物理推理、模式识别、编码能力、设计流畅性和图像上下文理解等方面测试不同的优势;因此您可以清楚地看到每个模型的优势或不足。

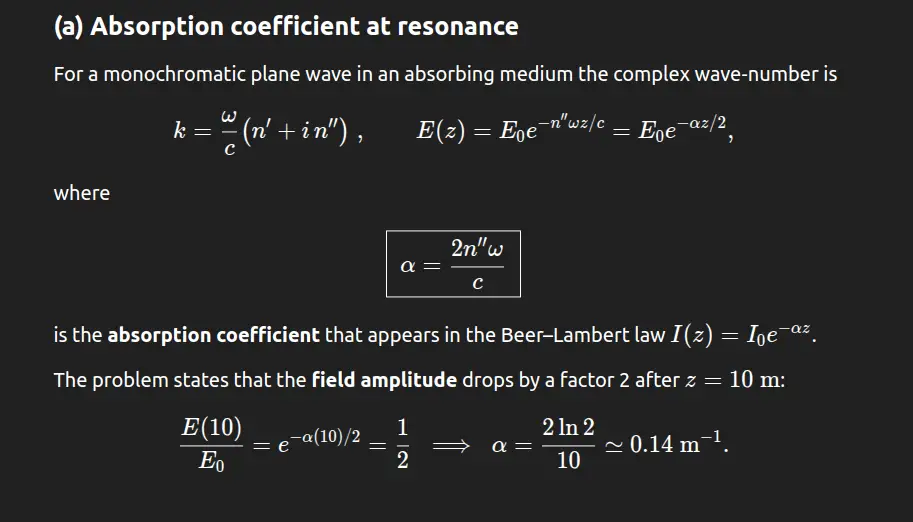

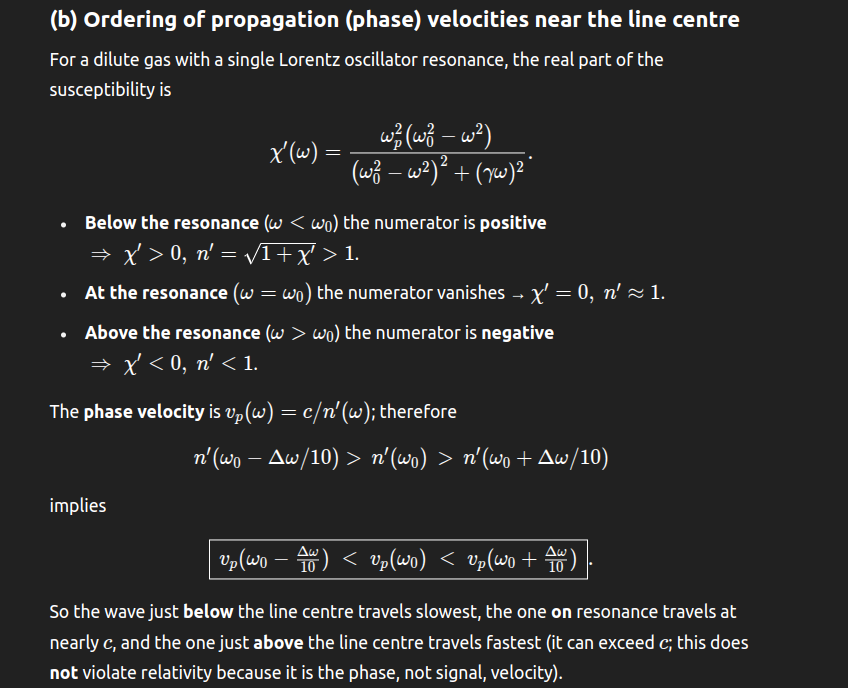

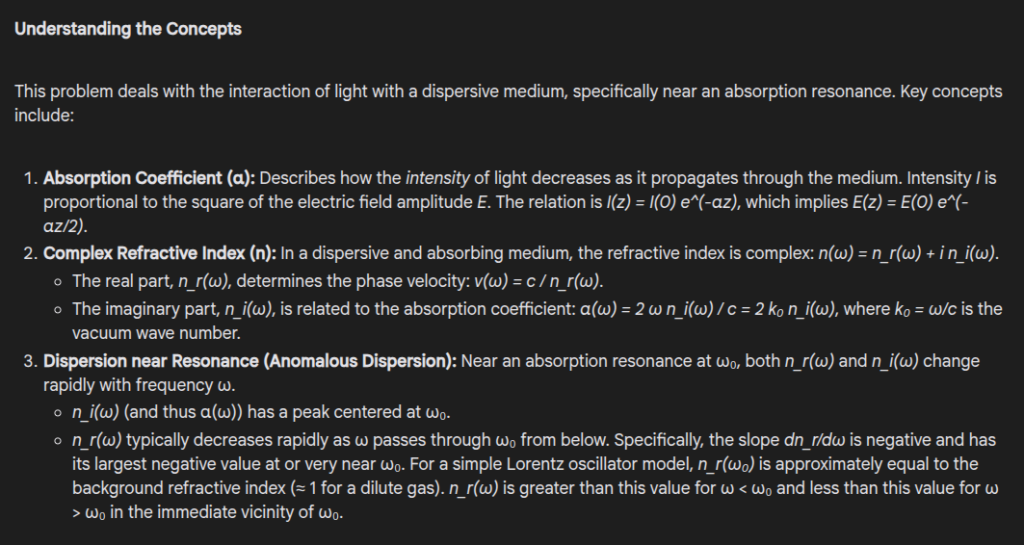

任务 1:物理推理

输入提示词:Dispersive Gaseous Medium. A dilute gaseous medium is found to exhibit a single optical resonance at frequency \\( \omega_0 = 2\pi \cdot 10^{15} \\) Hz. The electric field of a plane wave at frequency \\( \omega_0 \\) propagating through this medium is attenuated by a factor of two over a distance of 10 meters. The frequency width of the absorption resonance is \\( \Delta \omega \\). (a) What is the absorption coefficient \\( \alpha \\) at resonance? (b) Arrange in ascending order the propagation velocities at frequencies \\( \omega_0, \omega_0 + \Delta \omega / 10 \\), and \\( \omega_0 – \Delta \omega / 10 \\). Show your reasoning. (c) If there were no other resonances in the medium, what are the approximate numerical values of the index of refraction and the propagation velocity on resonance?

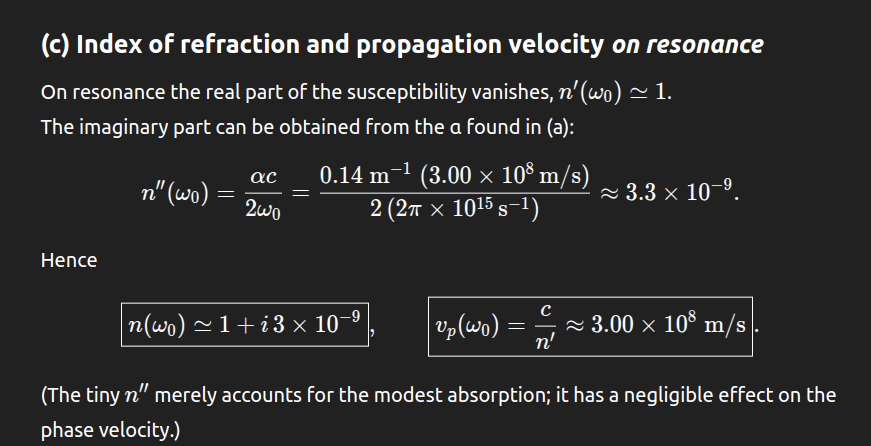

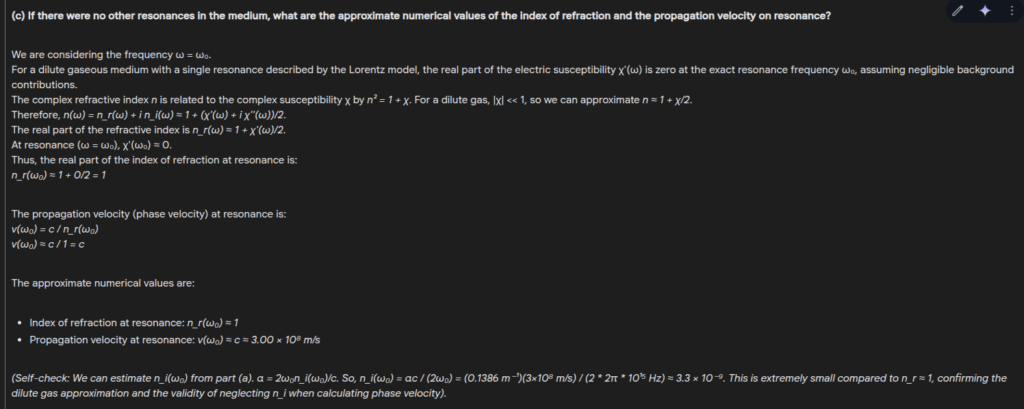

o3 输出:

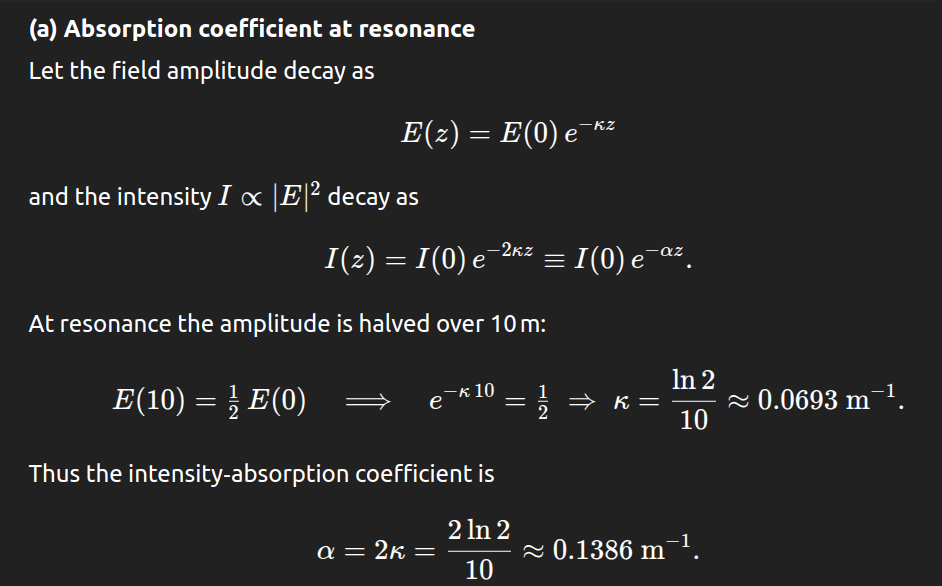

o4-mini 输出:

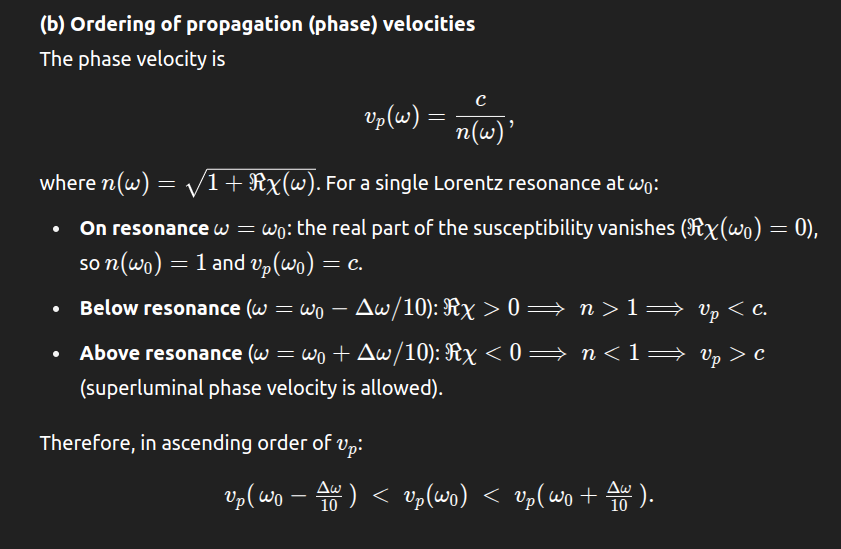

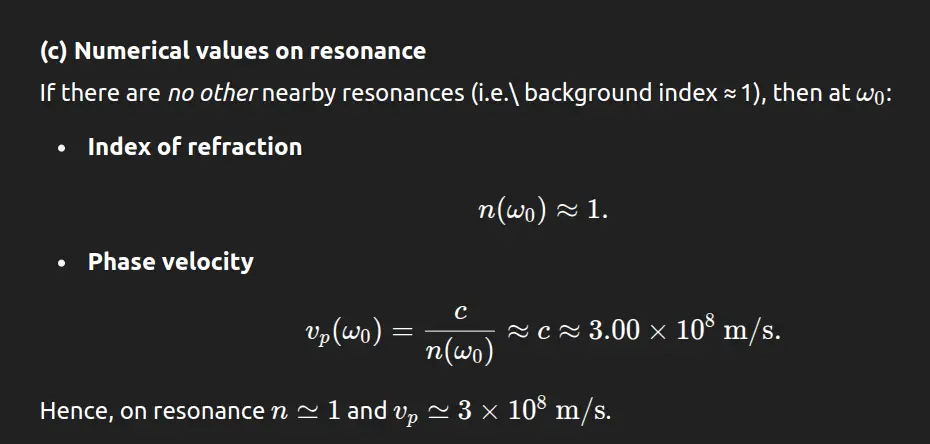

Gemini 2.5 输出:

输出结果对比

| 标准 | O3 | O4-mini | Gemini 2.5 |

| 吸收系数计算 | 推导正确;使用了场衰减方程和比尔-朗伯定律 | 正确、简明;清楚地使用 κ 并与α 联系起来 | 正确、详细;使用对数变换并包含单位 |

| 相位速度排序 | 正确,数学清晰,物理解释正确 | 正确,逻辑推理清晰 | 正确,概念性强,推理直观 |

| 共振频率和速度 | 精确的数值,包括单位换算和含义 | 近似但清晰;假定背景指数≈1 | 定性解释;定量略少 |

| 解释的清晰度和深度 | 深入但技术性强 | 简明扼要,便于学生理解 | 概念丰富,结构合理;可读性强 |

最终结论

所有三种模式都能提供正确、连贯的答案,但 Gemini 2.5 的整体表现最为突出。O3 在技术上最为严谨,而 O4-mini 则在速度和清晰度方面表现出色。Gemini 2.5 在深度、概念清晰度和结构化表达之间取得了最佳平衡。它不仅能提供正确的结果,还能以直观的推理解释基本的物理原理,是理解和验证的理想选择。

任务 2:数字推理

输入提示:Select the number from among the given options that can replace the question mark (?) in the following series: 16, 33, 100, 401,?

- 1235

- 804

- 1588

- 2006

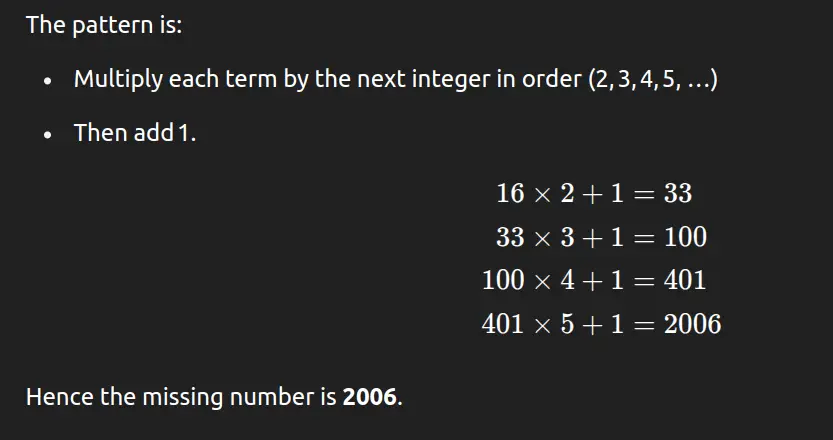

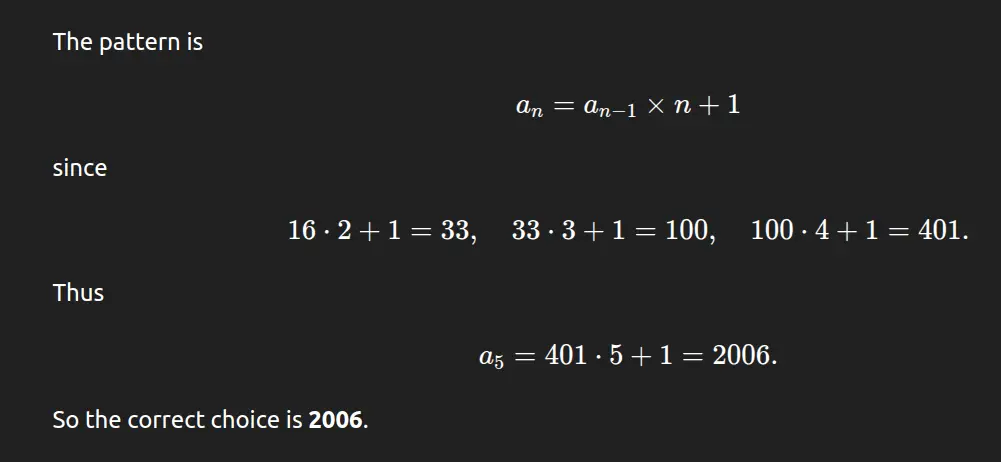

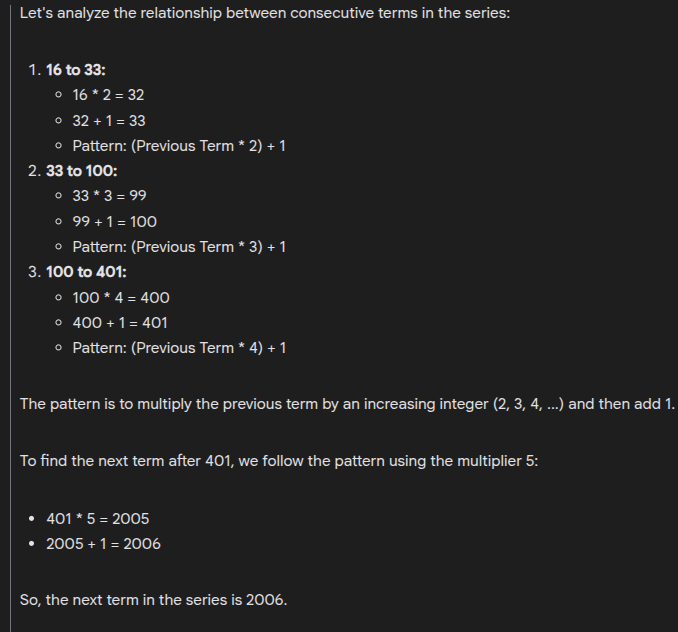

o3 输出:

o4-mini 输出:

Gemini 2.5 输出:

输出结果对比

| 标准 | O3 | O4-mini | Gemini 2.5 |

| 正确性 | 正确答案(2006) | 正确答案(2006) | 正确答案(2006) |

| 模式识别 |

明确指出乘数递增 +1 | 简洁地识别递归公式 | 逐步引导逻辑 |

| 解释风格 | 略有技术性,但整洁 | 简洁明了 | 最详细、最直观 |

| 学生清晰度 | 适合中级学习者 | 便于快速理解 | 适合所有水平 |

最终结论:

所有三个模型都能正确识别图案并得出正确答案,即 2006 年。Gemini 2.5 提供了详细的分步解释,而 O3 则清楚地解释了逻辑,但 O4-mini 则以其优雅和数学精确性脱颖而出。O4-mini 将序列表达为一个一般公式:an=an-1×n+1a_n = a_{n-1} \times n + 1an=an-1×n+1,以最简洁、最有条理的方式捕捉到了基本模式。因此,它非常适合那些喜欢清晰和紧凑推理的学习者。O4-mini 提供了最佳的整体解释。

任务 3:编码任务

输入提示词:Design and implement a data structure for Least Recently Used (LRU) cache. Implement the class `LRUCache` with the following methods:

– `get(key: int) -> int`: Return the value of the key if it exists, otherwise return -1.

– `put(key: int, value: int) -> None`: Update the value of the key if it exists, or insert the key-value pair if it doesn’t. When the cache reaches its capacity, it should invalidate the item that has been used least recently.

The cache should operate in O(1) time complexity for both operations.

o3 代码:

class Node:

"""Doubly‑linked‑list node holding a cache entry (key, value)."""

__slots__ = ("key", "value", "prev", "next")

def __init__(self, key: int, value: int):

self.key = key

self.value = value

self.prev = None

self.next = None

class LRUCache:

def __init__(self, capacity: int):

if capacity None:

"""Insert node right after head (MRU position)."""

node.prev = self.head

node.next = self.head.next

self.head.next.prev = node

self.head.next = node

def _remove(self, node: Node) -> None:

"""Unlink node from list."""

node.prev.next = node.next

node.next.prev = node.prev

# ───────────────────────── Public API ────────────────────────────────

def get(self, key: int) -> int:

"""Return value if present; else ‑1. Marks entry as recently used."""

if key not in self.map:

return -1

node = self.map[key]

self._remove(node)

self._add_to_front(node)

return node.value

def put(self, key: int, value: int) -> None:

"""

Insert/update (key,value).

If capacity exceeded, evict the least‑recently‑used entry.

"""

if key in self.map: # Update existing

node = self.map[key]

node.value = value

self._remove(node)

self._add_to_front(node)

return

# Insert new key

node = Node(key, value)

self.map[key] = node

self._add_to_front(node)

# Evict if over capacity

if len(self.map) > self.cap:

lru = self.tail.prev # Real LRU node

self._remove(lru)

del self.map[lru.key]

o4-mini 代码:

class Node:

__slots__ = ('key', 'value', 'prev', 'next')

def __init__(self, key: int = None, value: int = None):

self.key = key

self.value = value

self.prev = None

self.next = None

class LRUCache:

def __init__(self, capacity: int):

self.capacity = capacity

self.cache = {} # key → Node

# Dummy head/tail

self.head = Node()

self.tail = Node()

self.head.next = self.tail

self.tail.prev = self.head

def _remove(self, node: Node):

"""Disconnect node from list."""

prev, nxt = node.prev, node.next

prev.next = nxt

nxt.prev = prev

def _add_to_front(self, node: Node):

"""Insert node right after head."""

node.next = self.head.next

node.prev = self.head

self.head.next.prev = node

self.head.next = node

def get(self, key: int) -> int:

if key not in self.cache:

return -1

node = self.cache[key]

# Move to front

self._remove(node)

self._add_to_front(node)

return node.value

def put(self, key: int, value: int) -> None:

if key in self.cache:

# Update existing node and move it to front

node = self.cache[key]

node.value = value

self._remove(node)

self._add_to_front(node)

else:

# Insert new node

new_node = Node(key, value)

self.cache[key] = new_node

self._add_to_front(new_node)

# Evict LRU if over capacity

if len(self.cache) > self.capacity:

# Tail.prev is LRU

lru = self.tail.prev

self._remove(lru)

del self.cache[lru.key]

Gemini 2.5 代码:

import collections

class Node:

"""Node for the doubly linked list."""

def __init__(self, key, value):

self.key = key

self.value = value

self.prev = None

self.next = None

class LRUCache:

def __init__(self, capacity: int):

if capacity Node mapping

# Initialize sentinel nodes for the doubly linked list

self.head = Node(0, 0) # Dummy head

self.tail = Node(0, 0) # Dummy tail

self.head.next = self.tail

self.tail.prev = self.head

def _remove_node(self, node: Node):

"""Removes an existing node from the linked list."""

prev_node = node.prev

next_node = node.next

prev_node.next = next_node

next_node.prev = prev_node

# Optional: clear node pointers for garbage collection if needed

# node.prev = None

# node.next = None

def _add_to_front(self, node: Node):

"""Adds a node right after the head (most recently used)."""

node.prev = self.head

node.next = self.head.next

self.head.next.prev = node

self.head.next = node

def get(self, key: int) -> int:

"""

Return the value of the key if it exists, otherwise return -1.

Moves the accessed node to the front (most recently used).

"""

if key in self.cache:

node = self.cache[key]

# Move accessed node to the front

self._remove_node(node)

self._add_to_front(node)

return node.value

else:

return -1

def put(self, key: int, value: int) -> None:

"""

Update the value of the key if it exists, or insert the key-value pair.

Moves the updated/inserted node to the front.

Evicts the least recently used item if capacity is exceeded.

"""

if key in self.cache:

# Key exists, update value and move to front

node = self.cache[key]

node.value = value

self._remove_node(node)

self._add_to_front(node)

else:

# Key doesn't exist, insert new node

new_node = Node(key, value)

self.cache[key] = new_node

self._add_to_front(new_node)

# Check if capacity is exceeded

if len(self.cache) > self.capacity:

# Evict the least recently used item (node before tail)

lru_node = self.tail.prev

self._remove_node(lru_node)

# Remove from cache as well

del self.cache[lru_node.key]

# Example Usage:

try:

cache = LRUCache(2)

cache.put(1, 1) # cache is {1=1}

print(f"Cache after put(1, 1): {[(k, v.value) for k, v in cache.cache.items()]}")

cache.put(2, 2) # cache is {1=1, 2=2}

print(f"Cache after put(2, 2): {[(k, v.value) for k, v in cache.cache.items()]}")

print(f"get(1): {cache.get(1)}") # returns 1, cache is {2=2, 1=1} (1 is now MRU)

print(f"Cache after get(1): {[(k, v.value) for k, v in cache.cache.items()]}") # Order in dict might not reflect LRU order

cache.put(3, 3) # LRU key 2 was evicted, cache is {1=1, 3=3}

print(f"Cache after put(3, 3): {[(k, v.value) for k, v in cache.cache.items()]}")

print(f"get(2): {cache.get(2)}") # returns -1 (not found)

cache.put(4, 4) # LRU key 1 was evicted, cache is {3=3, 4=4}

print(f"Cache after put(4, 4): {[(k, v.value) for k, v in cache.cache.items()]}")

print(f"get(1): {cache.get(1)}") # returns -1 (not found)

print(f"get(3): {cache.get(3)}") # returns 3

print(f"Cache after get(3): {[(k, v.value) for k, v in cache.cache.items()]}")

print(f"get(4): {cache.get(4)}") # returns 4

print(f"Cache after get(4): {[(k, v.value) for k, v in cache.cache.items()]}")

except ValueError as e:

print(f"Error: {e}")

输出结果对比

| 标准 | o3 | o4-mini | Gemini 2.5 |

| 可读性 |

出色的结构和注释 | 非常简洁,可读性较差 | 清晰明了的注释 |

| 设计与模块化 | 良好的模块化,使用私有方法 | 简约,缺乏模块安全性 | 模块化的辅助方法和检查 |

| 性能 | 使用 __slots__和哨兵达到最佳效果 | 最优,内存效率高 | 最优化,提供可选的 GC 建议 |

| 安全性和鲁棒性 | 强大的验证和简洁的错误处理 | 缺乏输入检查(如容量 ≤ 0) | 包括验证和安全保护 |

最终结论

o3 在可读性、安全性、设计和性能方面实现了最佳平衡,因此最适合生产和长期使用。

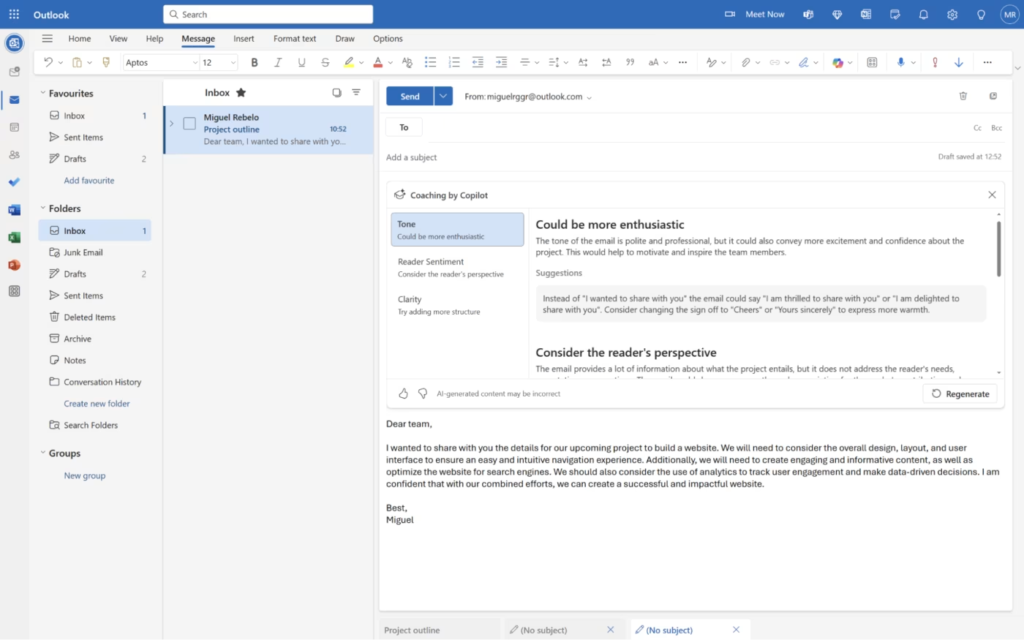

任务 4:创建网页

输入提示: Design a responsive personal portfolio webpage using HTML and CSS. The page should include the following sections:

1. Header: Display the user’s name and a brief tagline.

2. About Me: A short paragraph describing the user’s background and skills.

3. Projects: Showcase at least three projects with titles, descriptions, and links.

4. Contact: Provide contact information or a contact form.

Ensure the design is clean and mobile-friendly. Use semantic HTML elements and include basic CSS styling to enhance the visual appeal. Avoid using external CSS frameworks; write custom CSS for styling.

Implement the webpage in a single HTML file with embedded CSS.

o3 输出:

o4-mini 输出:

Gemini 2.5 输出:

输出结果对比

| 特征 | o3 | o4-mini | Gemini 2.5 |

| 设计美学 | 现代、多彩的渐变标题和统一的主题颜色 | 干净简约,有基本的边框和框阴影 | 布局简洁,设计极简。利用容器宽度和衬垫实现响应性。 |

| 代码结构和语义 | 出色地使用语义 HTML 和注释;统一的 BEM 风格类命名 | 简洁的语义 HTML,但较少模块化或注释 | 结构合理,HTML、CSS 和 JS 分离清晰。注重语义 HTML,正确使用

|

| 响应性 | 通过 clamp()、自动适应网格和媒体查询实现高度响应 | 利用 flex-wrap 和简单的媒体查询实现基本的响应性 | 良好的响应性,可针对各种屏幕尺寸进行动态调整,确保在各种设备上都能获得适当的用户体验。 |

| 包含的功能 | 功能齐全:页眉、关于、项目网格、联系方式(表单和信息)、简洁的页脚 | 类似的部分,但在布局、交互性和样式的精细度方面缺乏打磨 | 类似的部分,但在布局、交互性和造型方面缺乏精细度 |

最终结论

它的用户界面更精致,响应速度更快,采用了现代 CSS 技术(如变量和箝位),整体呈现更专业。它可用于生产,并展示了对 CSS 的深入掌握。

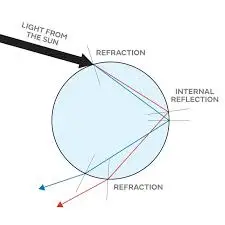

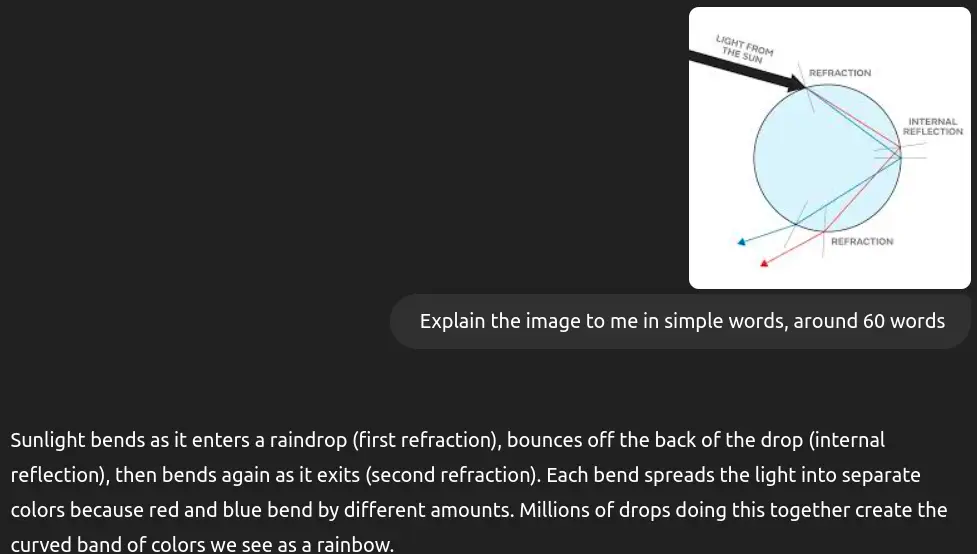

任务 5:图像分析

输入图像:

输入提示词:Explain the image to me in simple words, around 60 words

o3 输出:

o4-mini 输出:

Gemini 2.5 输出:

输出结果对比

| 对比项 | o3输出 | o4-mini输出 | Gemini 2.5输出 |

| 清晰度 | 清晰、简单、易懂。 | 略微详细,仍然清晰。 | 简单易懂。 |

| 解释深度 | 平衡的解释,包含重要细节。 | 更详细地说明颜色如何弯曲。 | 对概念的解释非常基本。 |

| 语调/风格 | 中立、科学,但又通俗易懂。 | 略微娓娓道来,依然正式。 | 非常有教育意义,便于快速理解。 |

| 长度 | 紧凑、简洁,涵盖所有要点。 | 更长,更有深度。 | 非常简短,切中要害。 |

最终结论

o3 输出在清晰、完整和简洁之间取得了最佳平衡,非常适合普通读者。它清晰地解释了彩虹的形成过程,没有过多的细节让读者不知所措,同时还涵盖了折射、内部反射以及多个水滴如何形成彩虹效果等基本方面。其简洁的风格使其易于消化和理解,是解释彩虹现象最有效的选择。

总体评价

O3 是各方面综合表现最好的。它在科学准确和通俗易懂之间取得了完美的平衡。Gemini 2.5 适合非常基础的理解,O4-mini 适合技术性较强的读者,而 O3 则最适合普通读者和教育目的,它提供了完整而引人入胜的解释,同时又不会过于技术化或过于简单化。

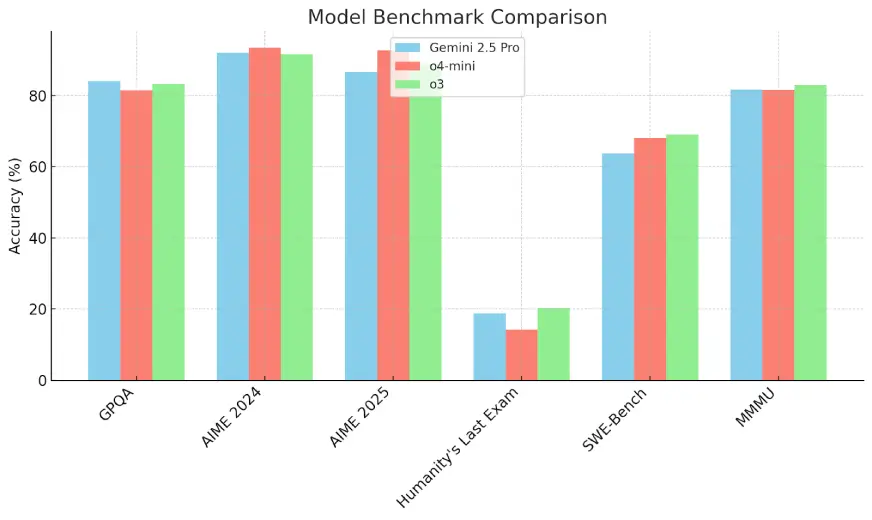

基准比较

为了更好地了解尖端人工智能模型的性能,让我们通过一系列标准化基准对 Gemini 2.5 Pro、o4-mini 和 o3 进行比较。这些基准评估了模型的各种能力,从高等数学和物理学到软件工程和复杂推理。

主要收获

- 数学推理:o4-mini 在 AIME 2024(93.4%)和 AIME 2025(92.7%)中遥遥领先,略高于 o3 和 Gemini 2.5 Pro。

- 物理知识:Gemini 2.5 Pro 在 GPQA 中得分最高(84%),表明其在研究生水平的物理学领域具有很强的专业知识。

- 复杂推理挑战:所有模型都在“人类最后一次考试”中表现不佳(<21%),其中 o3 表现最好,仅为 20.3%。

- 软件工程:o3 在 SWE-Bench 考试中取得 69.1%,超过 o4-mini(68.1%)和 Gemini 2.5 Pro(63.8%)。

- 多模态任务:o3 在 MMMU(82.9%)中也名列前茅,但差距不大。

解释和影响

这些结果凸显了每个模型的优势:o4-mini 在结构化数学基准方面表现出色,Gemini 2.5 Pro 在专业物理方面大放异彩,而 o3 则在编码和多模态理解方面表现出均衡的能力。在 “人类最后的考试 ”中得分较低,这表明在抽象推理任务方面还有改进的余地。

小结

归根结底,o3、o4-mini 和 Gemini 2.5 Pro 这三种模型都代表了人工智能推理的最前沿,而且各有所长。o3 凭借其图像驱动的思维链和在各种基准测试中的强劲性能,在软件工程、深度分析任务和多模态理解方面表现出色。

Gemini 2.5 Pro 的超大上下文窗口和对文本、图像、音频和视频的本地支持,使其在研究生物理和大规模多模态工作流中具有明显优势。在它们之间做出选择取决于您的具体需求(例如,使用 o3 进行深度分析,使用 o4-mini 进行快速数学精度分析,或使用 Gemini 2.5 Pro 进行大规模多模态推理),但无论如何,这些模型都在重新定义人工智能的功能。

常见问题

O 模型(O3、O4-mini)与 Gemini 2.5 的主要区别是什么?

Gemini 2.5 pro 支持多达 200 万个词组的上下文窗口,明显大于 O 模型。

哪种模型更适合编码任务?O 模型还是 Gemini 2.5?

在高级编码和软件工程任务中,O3 和 O4-mini 通常优于 Gemini 2.5。不过,在需要大上下文窗口或多模态输入的编码项目中,Gemini 2.5 更受青睐。

这些模型的价格比较如何?

就输入和输出令牌而言,Gemini 2.5 Pro 的成本效益大约是 O3 的 4.4 倍。这使得 Gemini 2.5 成为大规模或预算有限的应用程序的首选。

这些模型的上下文窗口尺寸是多少?

Gemini 2.5 Pro:高达 200 万个标记O3 和 O4-mini:通常支持高达 20 万个标记Gemini 的超大上下文窗口使其能够一次性处理更大的文档或数据集。

所有这些模型都支持多模态吗?

是的,但有一些关键区别:O3 和 O4-mini 包括视觉功能(图像输入)。Gemini 2.5 Pro 本身具有多模态功能,可处理文本、图像、音频和视频,因此在处理跨模态任务时用途更广。

暂无评论内容